La Search Console devient non seulement de plus en plus complète mais aussi de plus en plus obscure. Vous trouverez ci-dessous un décryptage des informations pouvant remonter dans la partie « couverture » de la Search Console. De nombreuses informations particulièrement intéressantes s’y trouvent. Encore faut-il savoir les décrypter. Voici un aperçu de l’ensembles des informations qui peuvent remonter dans Search Console, les causes et la/les solutions pour les résoudre.

« Discovered – Currently Not Indexed »

Cause : l’URL est connue de Google, souvent par des liens ou un plan du site XML, et se trouve dans la file d’attente d’exploration, mais Googlebot n’a pas encore eu le temps de l’explorer. Cela indique un problème de budget d’exploration.

Solution : s’il ne s’agit que de quelques pages, déclenchez une analyse manuellement en soumettant les URL dans Google Search Console.

S’il y en a un nombre important, investissez du temps dans une correction à long terme de l’architecture du site Web (y compris la structure des URL, la taxonomie du site et les liens internes) pour résoudre les problèmes de budget d’exploration à leur source.

« Crawled – Currently Not Indexed »

Cause : Googlebot a exploré l’URL et a trouvé le contenu mais a décidé de ne pas l’indexer. Cela est le plus souvent dû à des problèmes de qualité (contenu de faible qualité, dupliqué ou encore considéré comme du spam).

Solution : Consulter la page et posez vous la question : Cette page est-elle légtime pour apparaître dans l’index Google ?

- Si la réponse est oui et que le contenu semble de mauvaise de qualité : Vous devez améliorer le contenu de la page (si ce dernier vous paraît pauvre en qualité) ou dans la cas où le contenu est de bonne qualité, vérifier si le contenu est bien accessible au bot Google.

- Si la réponse est oui et que le contenu semble être de qualité acceptable, vérifiez si le contenu est accessible au bot Google en désactivant le JavaScript par exemple. Google est capable d’indexer du contenu généré par JavaScript, mais c’est un processus plus complexe que le HTML car il y a deux vagues d’indexation chaque fois que JavaScript est impliqué.

- Si la réponse est non, optez pour une redirection 301 ou une 410 (gone).

« Duplicate Without User-Selected Canonical »

Cause : la page est considérée par Google comme un contenu en double, mais ne présente pas d’url canonique, indiquant l’url de référence. Google a décidé que cette page ne devait pas être indexée.

Solution : Indiquer systématiquement une url canonique (auto canonique ou pointant vers une autre page) en utilisant les liens rel = canonical, pour chaque URL à explorer sur votre site Web.

« Duplicate, Submitted URL Not Selected as Canonical »

Cause : Même problème que précédemment, sauf dans ce cas, vous avez explicitement demandé l’indexation de cette URL (en l’intégrant par exemple dans votre sitemap XML.

Solution : Indiquer systématiquement une url canonique (auto canonique ou pointant vers une autre page) en utilisant les liens rel = canonical, pour chaque URL à explorer sur votre site Web. Enfin, assurez-vous de n’inclure que les pages indexables dans vos sitemaps xml.

« Duplicate, Google Chose Different Canonical Than User »

Cause : Ici vous avez fait le boulot correctement. Vous avez identifié des pages en duplication et donc intégré des balises canoniques. Cependant Google a décidé qu’une autre page faisait une meilleure canonique.

Solution : Google suggère de marquer ces URLs comme dupliquées de la canonique. Autrement dit, inspectez l’URL pour voir l’URL canonique sélectionnée par Google. Si vous êtes d’accord avec Google, modifiez le lien rel = canonical. Sinon, travaillez sur l’architecture de votre site Web pour réduire la quantité de contenu en double et envoyer des signaux de classement plus forts à la page que vous souhaitez devenir canonique.

Submitted URL Not Found (404)

Cause : L’url, soumise à Google (généralement via un sitemap XML) répond avec un code erreur 404.

Solution: Retirez les urls en 404 de vos sitemaps (cela nécessite de les mettre à jour régulièrement).

Redirect Error

Cause : Googlebot a rencontré un problème avec une redirection. Les causes les plus fréquentes sont les boucles de redirections et les chaînes de redirections.

Solution: Utilisez un crawler (screaming frog, Oncrawl, etc …) pour identifier ces chaînes ou boucles de redirection. Sinon vous pouvez aussi utiliser l’excellent https://httpstatus.io/

« Servor Error (5XX) »

Cause : Les serveurs ne sont pas capables d’afficher la page au moment au Googlebot souhaite y accéder. Il s’agit généralement d’un problème ponctuel sans réelle conséquence. Il convient toutefois de vérifier si le problème ne persiste pas dans la durée.

Solution : Pas d’inquiétude, l’erreur disparaîtra rapidement. Si la page est stratégique, vous pouvez demander à Googlebot d’inspecter à nouveau l’URL en demandant l’indexation dans l’inspection d’URL. Si l’erreur se reproduit, il est conseillé de se rapprocher de son hébergeur.

« Crawl anomaly »

Cause : Googlebot n’arrive pas à explorer correctement votre page.

Solution : Vérifiez le code HTTP de la page ou encore si celle-ci n’est pas bloquée par le robots.txt

Indexed, Though Blocked by Robots.Txt

Cause : Google a décidé d’indexer votre page malgré les consignes du robots.txt. La raison ? Google estime que votre page est intéressante et légitime pour être affichée dans les résultats de recherche.

Solution : Si véritablement vous ne souhaitez pas voir l’url indexée malgré le blocage du robots.txt, il est recommandé d’utiliser la solution du <meta name= »googlebot » content= »noindex« > dans le header de votre page.

Bon à savoir : Les URL avec une mention dans le header « noindex » seront quand même explorées mais moins fréquemment.

« Indexed, Not Submitted in Sitemap »

Cause : l’URL découverte par Google (généralement) via un lien et indexée n’est pas poussée dans le sitemap xml.

Solution : Veillez à ce que toutes les urls utiles pour le SEO soient présentes dans vos sitemaps xml. Par ailleurs veillez à ce que ces derniers soient régulièrement mis à jour.

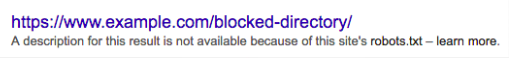

« Blocked by Robots.Txt »

Cause: La ou les pages sont bloquées par le robots.txt (exemple : Disallow : /category/*)

Solution: Si vous souhaitez que vos pages soient indexées dans Google, il faut alors modifier le robots.txt. Attention nous l’avons vu précédemment, Google peut, malgré le blocage du robots.txt, indexer une page. Si vous ne souhaitez pas la voir apparaître dans la SERP, utilisez plutôt une balise noindex.

Submitted URL Blocked by Robots.Txt

Cause: L’url soumise via un sitemap xml est bloquée par le robots.txt

Solution : Si l’url est légitime à l’indexation, vous devez corriger votre robots.txt. Sinon mettez à jour vos sitemaps et intégrer des règles pour ne faire figurer que des urls destinées au SEO.

Submitted URL Marked ‘Noindex’

Cause: L’url soumise via un sitemap xml est bloquée par une balise « noindex »

Solution : Si l’url est légitime à l’indexation, vous devez retirer le « noindex ». Sinon mettez à jour vos sitemaps et intégrer des règles pour ne faire figurer que des urls destinées au SEO.

Submitted URL Returns Unauthorized Request (401)

Cause: Google n’arrive pas à crawler une page car cette dernière retourne un code erreur 401. Autrement dit, la page est protégée par un mot de passe.

Solution: S’il n’y a pas de raison de protéger le contenu contre l’indexation, supprimez l’obligation d’autorisation. Sinon, supprimez l’URL du plan du site XML.

Submitted URL Has Crawl Issue

Cause: Quelque chose semble empêcher Google de crawler votre page.

Solution: Vérifier si l’accessibilité de la page (code http, robots.txt) ainsi que celui du contenu (Javascript par exemple). N’hésitez pas à utiliser l’outil « inspecter l’url » dans Search Console, de nombreuses informations pourront vous aider à identifier la source du problème.

Submitted URL Seems to Be a Soft 404

Cause : Une url est soumise via sitemap XML mais Google estime qu’elle est associée à une erreur « soft 404 » – c’est-à-dire que le serveur répond avec un code de succès de 200 mais la page :

- N’existe pas.

- Propose du contenu très léger (exemple : Page catégorie vide)

- Possède une redirection inappropriée

Solution: Si cette page n’a pas d’intérêt d’un point de vue SEO et si vous souhaitez que Google ne vienne plus l’explorer, optez pour une 410.

Si la page était légitime d’un point de vue SEO mais qu’une autre page la remplace, optez pour une redirection 301.

Si cette page est légitime pour l’internaute mais pas pour le SEO : Améliorer le contenu de la page et mettez en place une balise canonique pointant vers la page référente.

0 commentaires