La cause la plus fréquente d’une baisse soudaine du trafic sur un site Web est une récente mise à jour de l’algorithme de recherche. Les pénalités, les redirections, les règles incorrectes du fichier robots.txt et les pertes de classement sont toutes d’autres raisons légitimes pour lesquelles vous pouvez constater une baisse du trafic sur votre site Web.

Heureusement, dans la plupart des cas, si vous êtes affecté par une baisse soudaine du trafic, vous pouvez vérifier quelques éléments en plus de ce que j’ai mentionné ci-dessus. Espérons qu’à la fin, vous serez en mesure de diagnostiquer pourquoi les choses ont pu changer.

Liste de contrôle de perte de trafic sur le site Web

Voici 11 points que j’aime vérifier si je remarque qu’un site connaît une baisse des visites mensuelles ou une baisse soudaine du trafic :

- Mises à jour des algorithmes

- Erreurs de suivi

- Règles Robots.txt

- Redirections

- Erreurs d’exploration

- Pertes de classement

- Modifications du plan de site XML

- Pénalités manuelles

- Désindexation

- Cannibalisation

- Modifications de la mise en page SERP

1. Mises à jour Google

Google ne cache pas qu’il publie plusieurs mises à jour tout au long de l’année, certaines plus importantes que d’autres. Malheureusement, essayer d’obtenir des détails solides sur les changements revient franchement à essayer d’obtenir du sang d’une pierre.

Cependant, un moyen simple de déterminer si votre site a pu être impacté par une mise à jour de l’algorithme est de garder un œil attentif sur les changements confirmés de Google lui-même.

Mais, de loin, le moyen le plus simple d’obtenir des informations sur les changements d’algorithme est d’utiliser des outils tels que Mozcast – de Moz.com et le capteur SEMrush de SEMrush. Si aucun de ceux-ci ne vous plaît , Algoroo est un autre outil de suivi d’algorithmes disponible gratuitement.

Si vous constatez qu’il y a effectivement eu une mise à jour récente, je vous recommande fortement de passer un peu de temps à analyser les sites qui ont été le plus touchés. Essayez de repérer toute corrélation entre eux et assurez-vous que votre site ne subit pas le même sort.

2. Erreurs de suivi / tracking

Même maintenant, je suis étonné de voir combien de webmasters et de propriétaires de sites parviennent à extraire leurs codes de suivi du site et se demandent pourquoi le trafic plonge.

Heureusement, c’est une erreur qui peut être facilement corrigée, mais à long terme, vous passerez à côté de données – donc plus vite vous la repérerez et la trierez, mieux ce sera !

Si vous remarquez qu’aucune session n’est soudainement enregistrée dans Google Analytics ou qu’une balise ne se déclenche pas, il est probable que les codes de suivi contiennent une erreur ou aient été entièrement supprimés. Si vous y avez accès, vérifiez que le code est présent et correct.

Vous pouvez également contacter vos développeurs et confirmer que le code de suivi est là où il doit être et qu’il fonctionne .

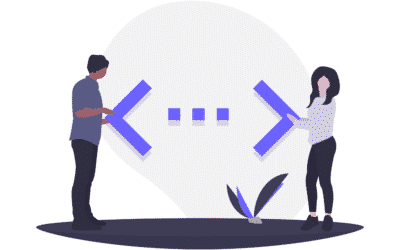

3. Robots.txt

Êtes-vous sûr que votre site n’empêche pas les moteurs de recherche d’explorer le fichier robots.txt ?

Il n’est pas rare que les développeurs laissent les fichiers robots.txt inchangés après la migration à partir d’un site Web de développement ou de transfert. La plupart du temps, lorsque cela se produit, c’est complètement accidentel.

Accédez au fichier robots.txt de votre site et assurez-vous que la règle suivante n’est pas présente :

Si c’est le cas, vous devrez supprimer la règle d’interdiction et renvoyer votre fichier robots.txt via Google Search Console et le testeur robots.txt .

0 commentaires